Solus est un OS Linux destiné à un usage desktop uniquement. Il a été créé par une communauté désirant désigner un OS desktop devenant une véritable alternative à Windows ou MacOS

Pour ma part, je suis convaincu que le fait de faire un focus unique sur la partie desktop est une excellente idée. Ici pas d’OS serveur, pas d’optimisation pour la partie serveur mais au contraire une optimisation de l’OS et des applications disponibles pour un usage workstation – c’est à mon sens le seul moyen de bien faire les choses, faire un focus fonctionnel précis répondant à des usages précis

Vous trouverez un article à propose de Solus sur le site de Korben: https://korben.info/solus-linux-user-friendly-refuse-de-devenir-usine-a-gaz.html

Télécharger l’ISO en version 1.1 depuis: https://solus-project.com/download/

Transformer une clé USB en clé USB bootable depuis l’ISO téléchargé – par exemple, sous Windows avec l’outil Rufus disponible sur http://rufus.akeo.ie/?locale=fr_FR

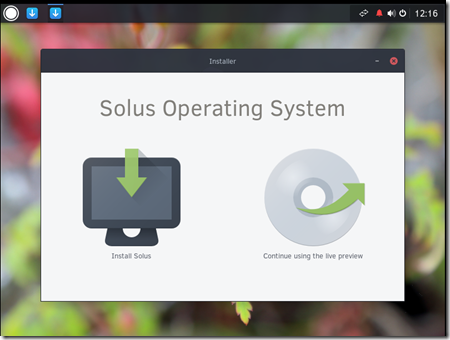

Démarrer sur la clé USB, après quelques secondes, vous obtenez un écran d’accueil, choisir “Instal Solus”

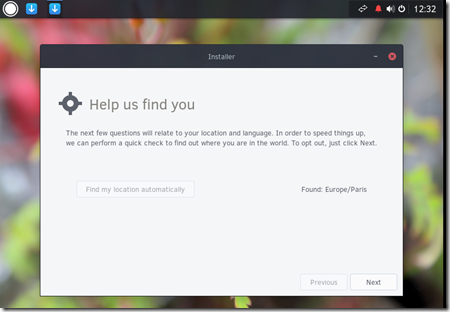

Cliquer sur “Find my location automatically”

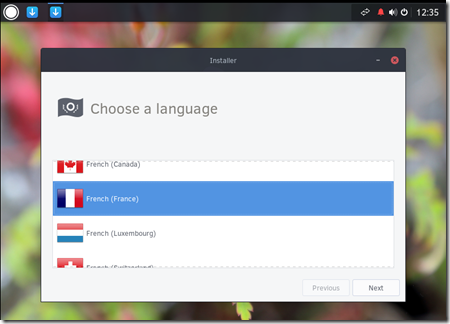

Choisir la langue désirée

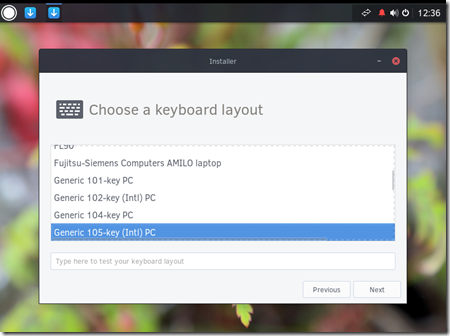

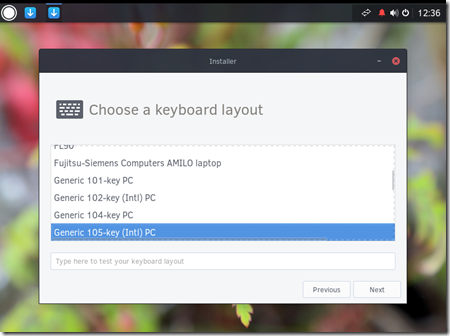

Garder les options de clavier par défault, à moins que vous ayez des besoins particuliers

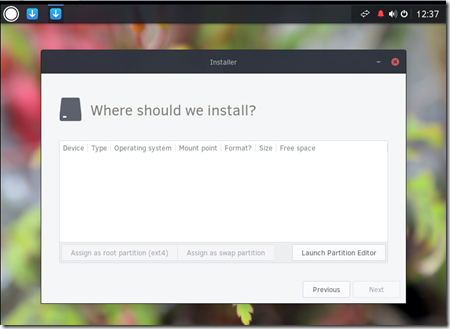

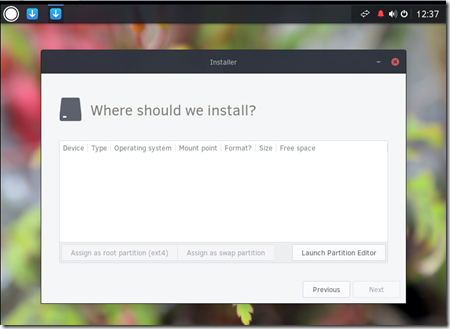

Sélectionner le disque sur lequel l’installation doit être effectuée

Cliquer ensuite sur le bouton “Launch Partition Editor”

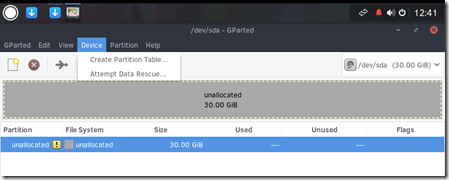

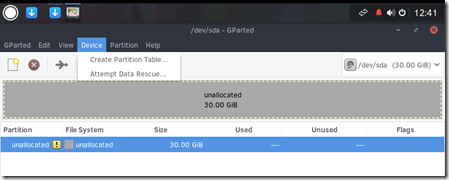

Nous considérons ici que le disque est vierge, sans partition existante et sans données

Cliquer sur le menu Device et choisir “Create Partition Table”

Choisir le type de table de partition “gpt” et cliquer sur le bouton “Apply”

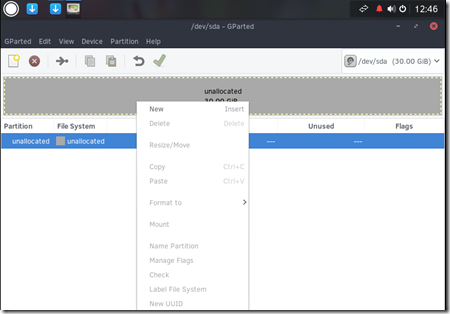

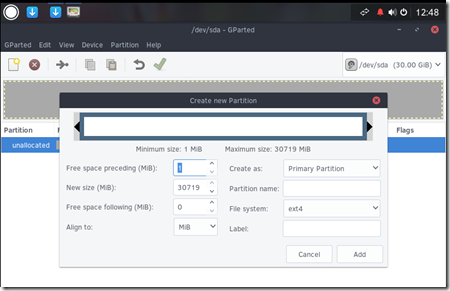

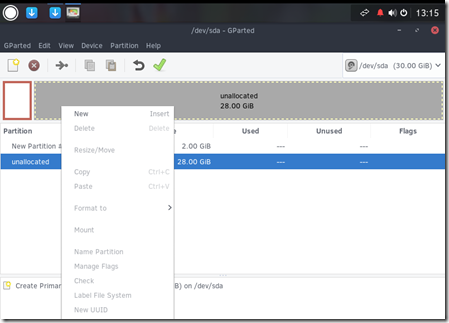

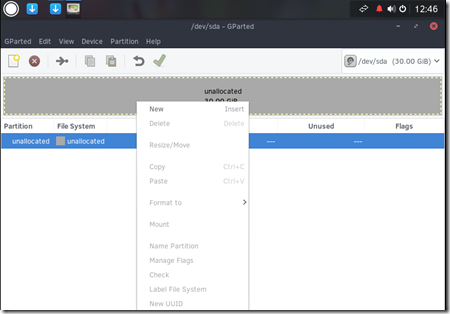

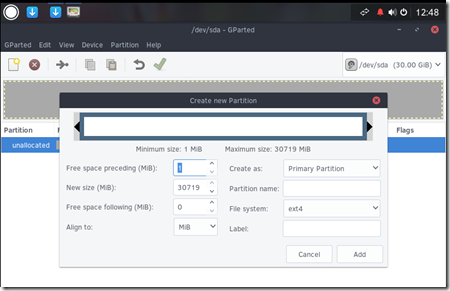

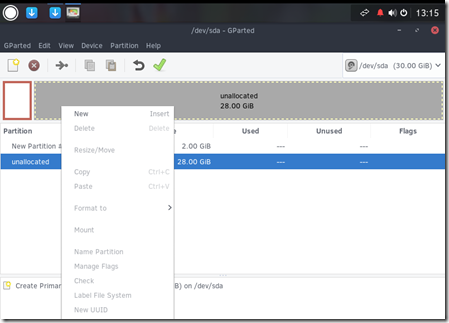

Ensuite, réaliser un clic-droit sur la zone “unllocated” et choisir “New”

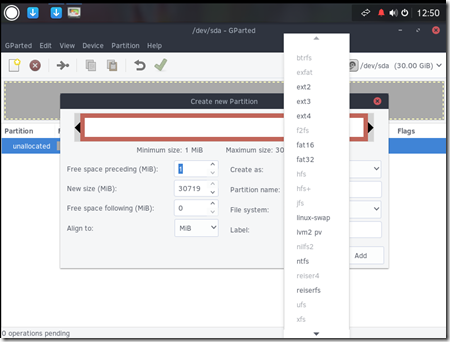

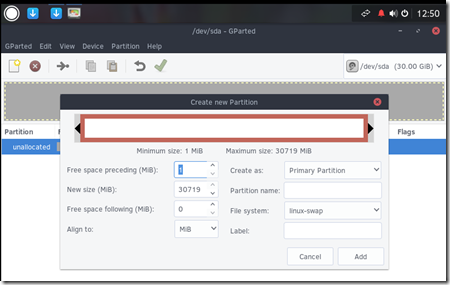

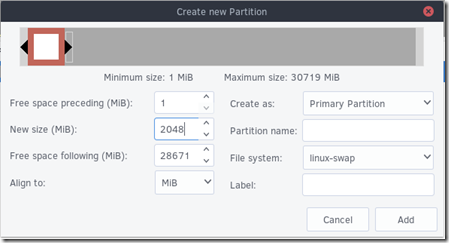

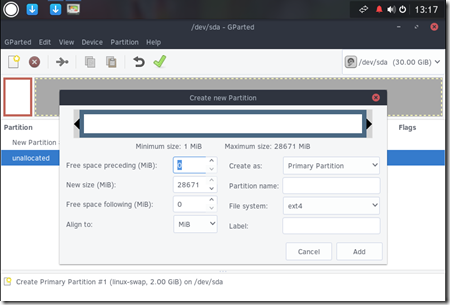

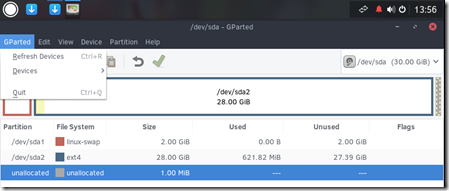

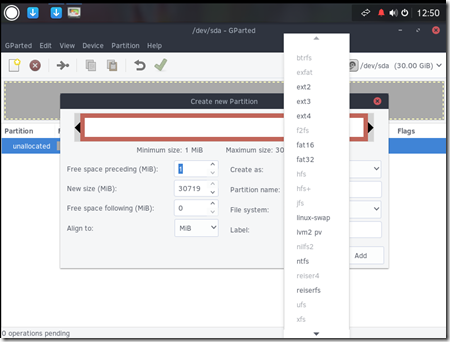

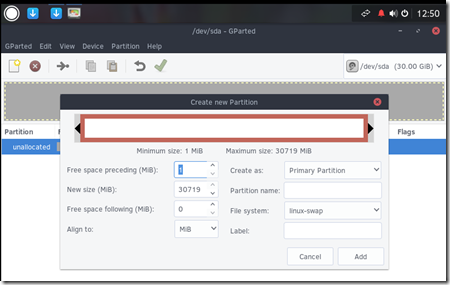

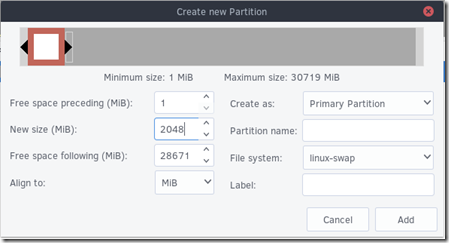

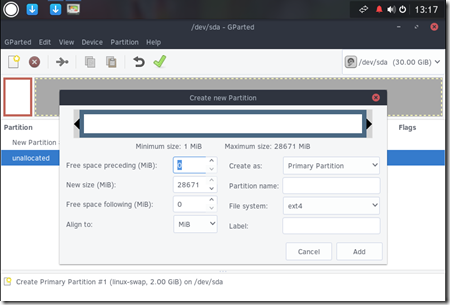

Sélectionner le menu “File system” et choisir “linux-swap”

Dans la zone “New size” entrer la valeur 2048 – Puis cliquer sur le bouton “Add” – Pour rappel, la partition de swap sert de zone tampon si votre espace en mémoire vive est saturé, pour un poste de travail une valeur à 2Go est largement suffisante

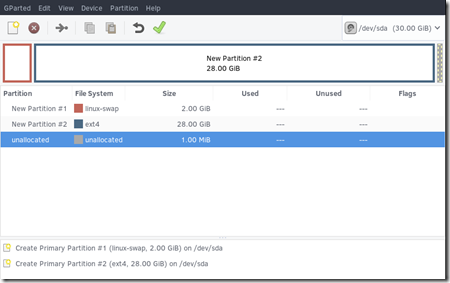

Réaliser à nouveau un clic-droit sur la zone “Unallocated”, choisir New

Laisser les valeurs par défaut: Pour “File system”, laisser “ext4” et laisser la taille maximum possible au niveau de l’attribut “New size” ; puis cliquer le bouton “Add” – La partition ext4 prendra donc l’intégralité du restant sur le disque. Pour rappel, la partition ext4 sert à stocker les fichiers ou les répertoires du systèmes et des applications

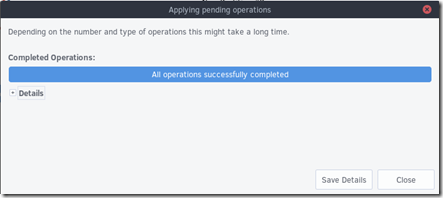

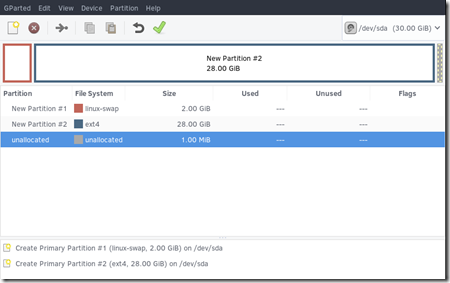

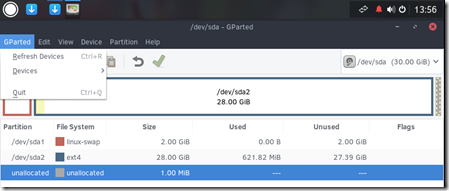

Au final, vous devez obtenir quelque chose qui ressemble à ceci:

Cliquer ensuite sur la coche verte à droite de la barre d’outils afin de formater les différentes partitions

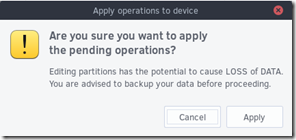

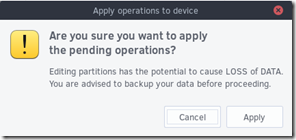

Cliquer sur le bouton “Apply”

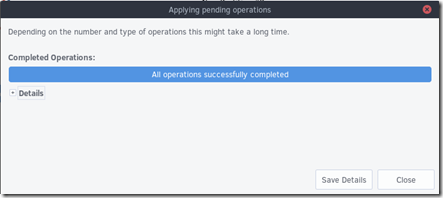

A la fin de l’opération de formatage, vous devez obtenir le message “All operations successfully completed”

Cliquer sur le bouton “Close”

Aller dans le menu “GParted” de l’utilitaire de partition et choisir la fonction “Quit”

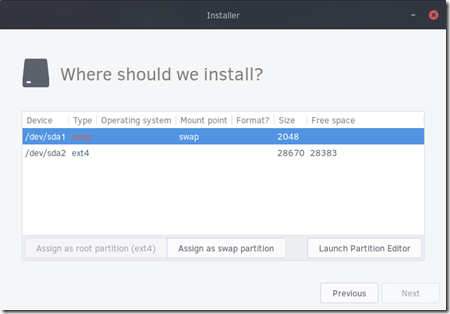

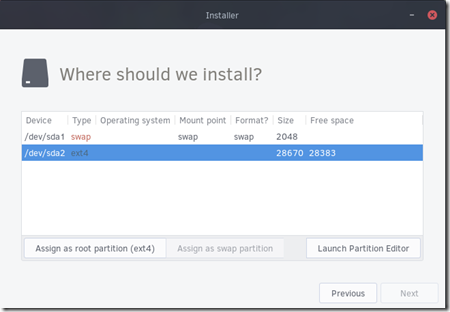

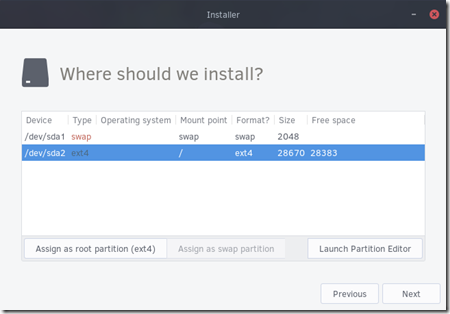

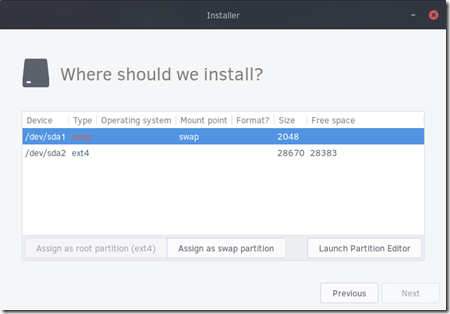

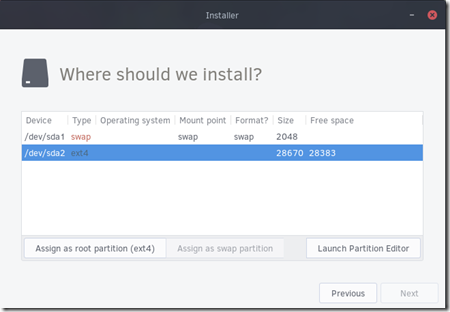

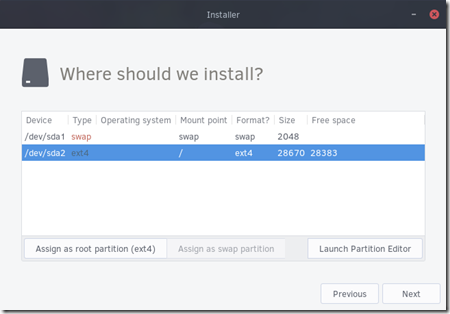

Vous revenez alors à l’utilitaire d’installation. Sélectioner la partition “swap” puis cliquer sur le bouton “Assign as swap partition”

Sélectionner la partition “ext4” puis cliquer sur le bouton “Assign as root partition ext4”

Puis cliquer le bouton “Next”

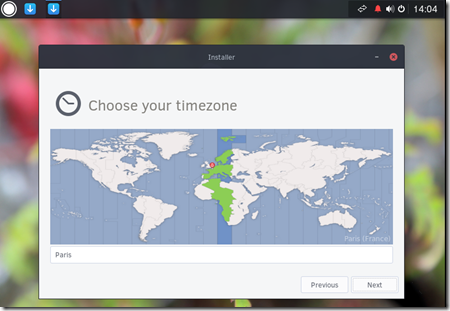

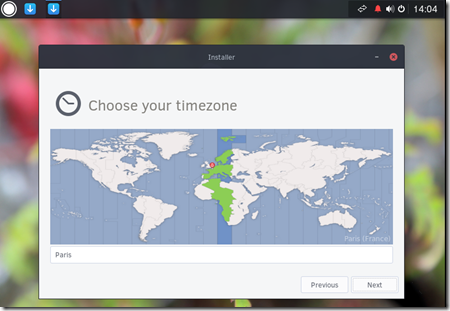

Choisir la TimeZone puis cliquer sur le bouton “Next”

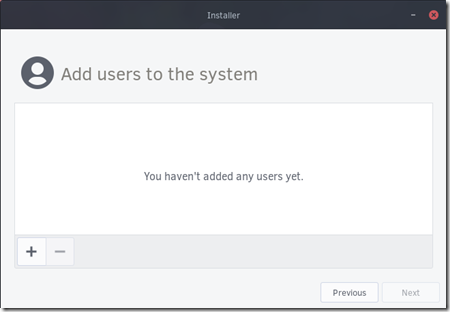

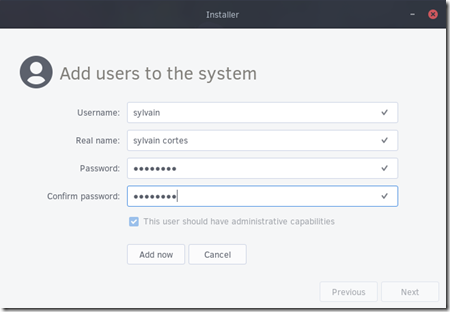

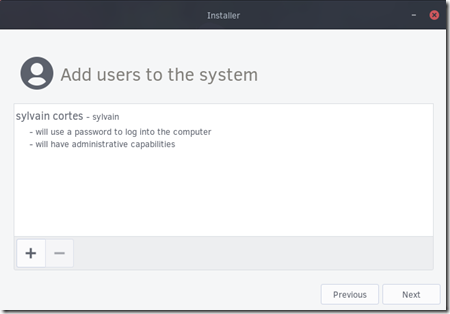

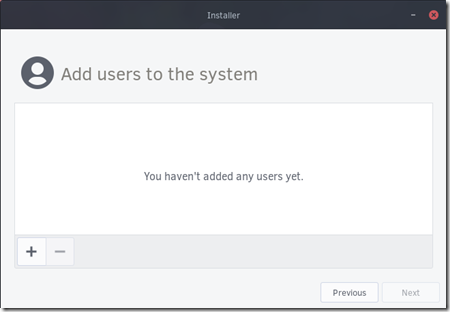

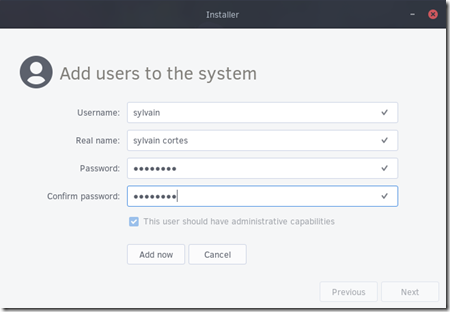

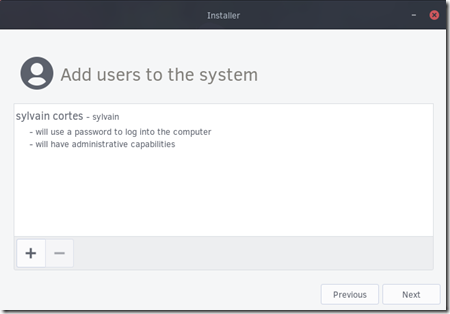

Rajouter au moins un utilisateur qui pourra se connecter au système une fois l’installation terminée – cliquer le bouton [+] et rajouter autant d’utilisateurs que désiré puis cliquer sur le bouton “Next”

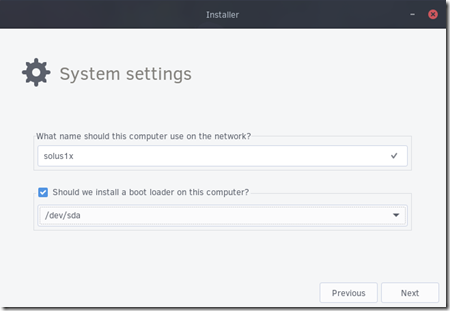

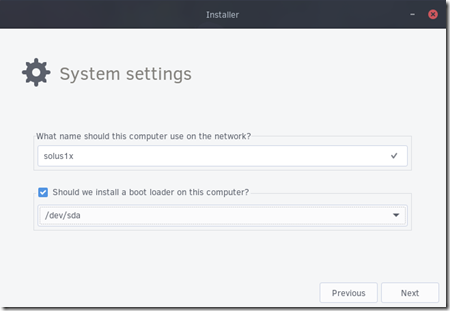

Fournir un nom (hostname) qui permettra d’identifier le système sur le réseau – Activer la fonction “Should we install a boot loader on ths computer ?” en cliquant sur la coche – Cliquer sur le bouton “Next”

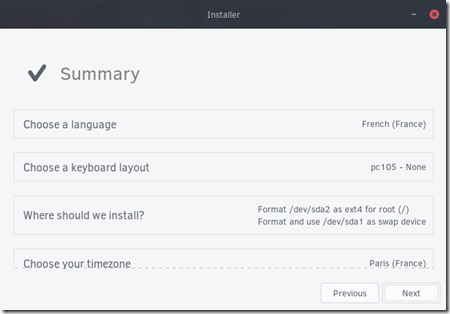

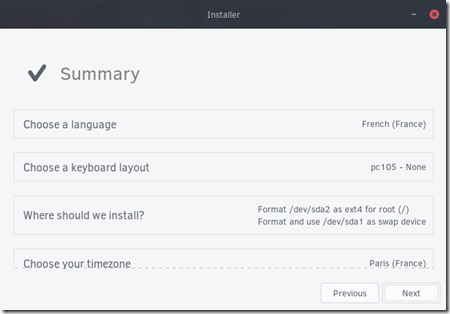

Vous arrivez ensuite à un écran présentant le récapitulatif de l’ensemble des paramètres que vous avez choisis. Vérifier les paramètres et cliquer sur le bouton “Next”

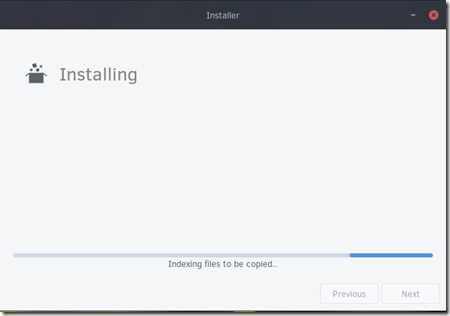

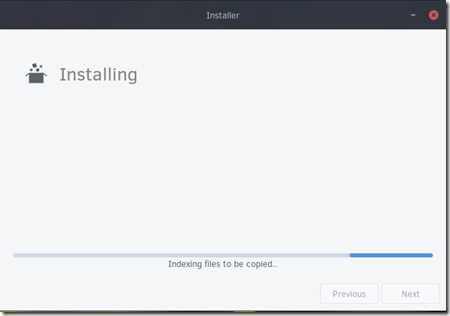

L’installation de l’OS Solus 1.1 sur le système de fichiers commence

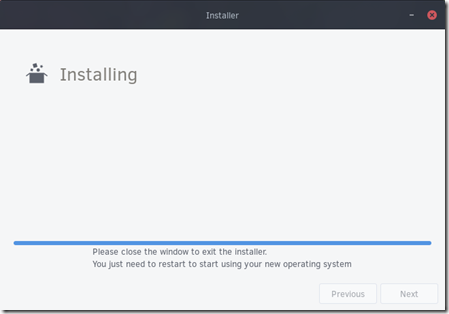

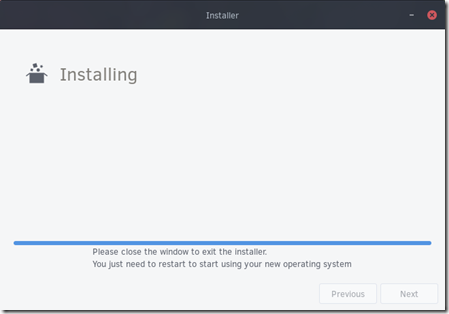

A la fin du procesus d’installation, cliquer sur la croix rouge en haut à droite de la fenêtre – puis déclencher un redémarrage du système après installation

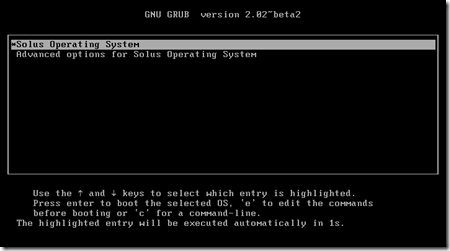

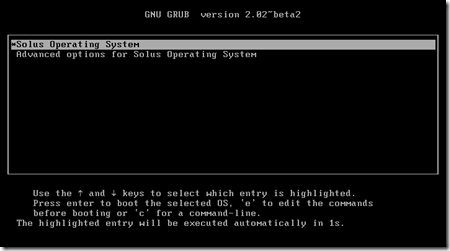

Le système redémarre

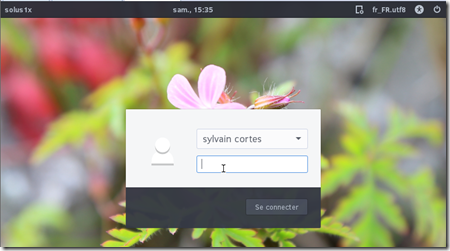

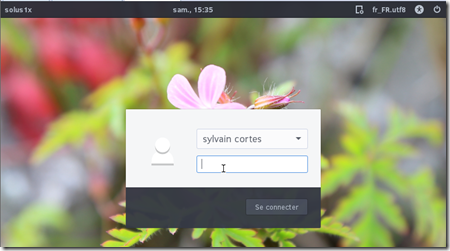

L’écran d’accueil avec la mire de login apparait – par défaut l’utilisateur créé pendant le processus d’installation est présent il suffit alors de renseigner le mot de passe et de tester ce nouvel OS plein de promesses !